X, У, Z,

А, Б, С.

Тема 7. Виды НС по анатомо-функциональному принципу: соматическая и вегетативная НС человека.

Тема 6. Периферическая НС человека.

1. Строение и функции периферической НС .

2. Эволюция периферической НС.

1.Особенности соматической НС человека, её эволюция.

2. Особенности вегетативной НС человека, её эволюция:

- симпатическая НС;

- парасимпатическая НС;

- метасимпатическая НС

Тема 8. Общее понятие о физиологии высшей нервной деятельности (ВНД)

1. Анализаторный аппарат человека:

- зрительная система;

- слух и равновесие;

- вкусовая система;

- обонятельная система;

- кожная рецепция;

- проприоцепция и интероцепция.

2. Первая и вторая сигнальные системы человека.

3. Типы высшей нервной деятельности (по Павлову)

Количественная характеристика опыта состоит в определении значений некоторых величин, полученных в результате опыта. Такие величины, которые могут принимать в результате опыта различные значения, причем до опыта невозможно предвидеть, какими именно они будут, называются случайными величинами.

Примерами случайных величин могут служить ошибки и результаты измерений, время безотказной работы прибора или системы рост и вес наугад выбранного человека, координаты точки нонадания (разрыва снаряда) нри выстреле, число попаданий при п выстрелах.

Мы будем обозначать случайные величины прописными буквами, преимущественно из конца латинского алфавита, а их конкретные значения — соответствующими малыми буквами. Нанример, случайные величины будем обозначать

а их конкретные значения, получаемые в результате опыта, — соответственно

x, y, z

Эти значения называются возможными значениями или реализациями случайных величин X, У, Z.

С каждой случайной величиной можно связать различные события. Типичным событием, связанным со случайной величиной, является событие, состоящее в том, что эта случайная величина примет в результате опыта какое-нибудь значение, принадлежащее данному множеству, безразлично какое именно.

Такое событие коротко называется попаданием случайной величины в данное множество.

4.2. Частота события.

Естественно сравнивать события по тому, как часто каждое из них появляется при повторении данного опыта. Если при повторении опыта одно событие появляется чаще, чем другое, то говорят, что первое вероятнее второго.

Для сравнения событий необходимо предположить, что данный опыт можно производить сколько угодно раз.

Частотой события называется отношение числа его появлений к числу всех произведенных опытов.

Таким образом, если при п опытах событие А появилось т раз, то его частота в дайной серии опытов равна т/п.

1.2.2.Условные частоты. В некоторых случаях частоту события приходится определять при дополнительном условии, что произошло некоторое другое событие. Чтобы определить частоту события А при условии, что произошло событие В, необходимо учитывать не все произведенные опыты, а только те из них, в которых произошло событие В.

Таким образом, если из п произведенных опытов событие В появилось в т опытах, причем в k: из этих т опытов появилось и событие А, то частота события Апри условии, что произошло событие В, равно k /т.

Эта частота, как правило, пе совпадает с частотой события А, вычисленной с учетом всех п произведенных опытов.

Частота события А, вычисленная с учетом только тех из произведенных опытов, в которых появилось событие В, называется условной частотой события А отпосительпо события В.

4.3. Свойства частот.

Событие называется невозможным и обозначается Æ, если оно не может произойти в результате данного опыта. Событие называется достоверным и обозначается Ώ, если оно

обязательно происходит в результате данного опыта, т.е. не может не произойти.

События А1, А2 ,…, Апназываются несовместными в данном опыте, если в результате этого опыта никакие два из пих пе могут появиться вместе.

Например,

· попадание и промах при одном выстреле,

· выпадение 1 очка, 2 очков и 3 очков нри одном бросании игральной кости.

Два события, несовместные в одном опыте, могут оказаться совместными в другом опыте. Например, попадание и промах несовместны при одном выстреле. Однако они совместны, если за один опыт считаются два выстрела.

Основные свойства частот событий.

1) Частота любого события представляет собой неотрицательное число, не превосходящее 1, причем частота невозможного события равна 0, а частота достоверного события равна 1.

2) Частота появления одного из несовместных событий, безразлично какого именно, равна сумме их частот. Это следует непосредственно из того, что число появлений сложного события, представляющего собой появление какого-нибудь из несовместных событий, равно сумме чисел появлений этих событий.

3) Частота совместного появления двух событий А и В равна частоте одного из них, умноженной на условную частоту другого. Для доказательства достаточно заметить, что если при п опытах А появилось т раз, а В – k раз, причем l раз вместе с А, а к – l раз без А, то частота совместного появления А и В равна l /п, частота А равна m/n, а условная частота В относительно А равна l/т.

Очевидно, что если частота события в данной серии опытов равна 0 (или 1), то из этого не следует, что событие невозможно (достоверно).

Так, например, если при пяти бросаниях монеты герб не появился ни разу, то из этого не следует, что появление герба невозможно.

4.4. Вероятность события.

Замечательный экспериментальный факт — основная закономерность, наблюдаемая в массовых случайных явлениях, — устойчивость частот событий при большом числе опытов.

Если при малом числе опытов частота события принимает совершенно случайно различные значения, то при неограпичеппом увеличении числа опытов она проявляет тенденцию стабилизироваться около некоторого характерного для данного события значения.

Допустим, что некоторый опыт неограниченно повторяется и после каждого опыта вычисляется частота события с учетом всех уже произведенных опытов.

При этом обнаруживается, что вначале, когда число произведенных опытов мало, случайный результат каждого опыта существенно изменяет частоту события.

Однако но мере возрастания числа опытов влияние результата каждого нового опыта уменьшается. Так, например, результат тысячного опыта изменяет частоту меньше, чем на 0,001. Частота как бы стремится перестать быть случайной и стабилизироваться около некоторого значения.

Устойчивость частот событий дает основание считать, что с каждым событием связано некоторое число — вероятность этого события, — около которого стремится стабилизироваться его частота.

Так, нанример, частота появления герба при бросании монеты, очевидно, должна стабилизироваться около 1/2. Следовательно, вероятность появления герба равна 1 /2.

Вероятность события А обозначается Р{А). Это, конечно, не исключает применения сокращенных обозначений, например Р{А) = р и т.п.

Понятие вероятности события является первичным в теории вероятностей и поэтому не нуждается в определении. Оно представляет собой результат абстракции, необходимой для построения любой теории. Отвлекаясь от сложных и несуществеппых колебаний частоты при неограпичеппом повторении опытов и оставляя основную, существенную закономерность, наблюдаемую в данном явлении, — устойчивость частоты, — мы и вводим абстрактное понятие вероятности события.

Вероятность события в данном опыте — его объективная характеристика. Она имеет вполне определенное значение независимо от того, собираемся мы производить опыты или нет.

4.5. Выборочное среднее.

Основная задача экспериментального изучения случайных величин состоит в том, чтобы установить, как распределяются экспериментальные точки на числовой оси, на плоскости или в пространстве.

Совокупность значений наблюдаемых величин, полученных в результате опытов, называется выборкой.

Получив выборку, необходимо прежде всего определить положение значений случайной величины на числовой прямой и их рассеивание, т.е. размеры занимаемой ими области.

За характеристику положения экспериментальных точек обычно принимают среднее арифметическое значение случайной величины, называемое выборочным средним. Предположим, что случайная величина X приняла в результате п опытов значения х1, … , хn .

Тогда выборочное среднее определяется формулой

Математическим ожиданием М(Х) дискретной случайной величины Х называется сумма произведений всех ее значений на соответствующие им вероятности:

n

М(Х)=∑ xiрi = x1р1 + x2р2+…+ xnрn

i=1

4.6. Выборочные дисперсия и среднее квадратическое отклонение.

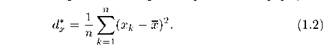

За экспериментальную характеристику рассеивания значений скалярной случайной величины обычно принимают среднее арифметическое значение квадратов отклонений экспериментальных значений случайной величины от выборочного среднего. Эта характеристика называется выборочной дисперсией случайной величины.

Если в результате п опытов случайная величина X приняла значения х1, … , хn , то ее выборочная дисперсия определяется формулой

Или же используя понятие вероятности

Получится, что дисперсия - это средний квадрат отклонений от среднего значения. (Математическое ожидание квадрата отклонения случайной величины от математического ожидания этой случайной величины).

То есть вначале рассчитывается среднее значение, затем берется разница между каждым исходным и средним значением, возводится в квадрат, складывается и затем делится на количество значений в данной совокупности.

Разница между отдельным значением и средней отражает меру отклонения. В квадрат возводится для того, чтобы все отклонения стали исключительно положительными числами и чтобы избежать взаимоуничтожения положительных и отрицательных отклонений при их суммировании.

Затем, имея квадраты отклонений, мы просто рассчитываем среднюю арифметическую. Средний – квадрат – отклонений.

Однако в чистом виде дисперсия не используется.

Это вспомогательный и промежуточный показатель, который используется для других видов статистического анализа.

Недостатком выборочной дисперсии с практической точки зрения является отсутствие наглядности — она имеет размерность квадрата случайной величины.

Поэтому за практическую характеристику рассеивания значений случайной величины обычно принимают выборочное среднее квадратическое отклонение, представляющее собой положительный квадратный корень из выборочной дисперсии, σ* =Ödx*

5. Энтропия как мера неопределенности

Описать случайные события можно не только в терминах вероятностей.

То, что событие случайно, означает отсутствие полной уверенности в его наступлении, что, в свою очередь, создает неопределенность в исходах опытов, связанных с данным событием.

Степень неопределенности различна для разных ситуаций.

Например, если опыт состоит в определении возраста случайно выбранного студента 1-го курса дневного отделения вуза, то с большой долей уверенности можно утверждать, что он окажется менее 30 лет;

Гораздо меньшую определенность имеет аналогичный опыт, если проверяется, будет ли возраст произвольно выбранного студента меньше 18 лет.

Для практики важно иметь возможность произвести численную оценку неопределенности разных опытов.

Введем такую количественную меру неопределенности.

Пусть опыт имеет n равновероятных исходов. Очевидно, что неопределенность каждого из них зависит от n, т.е. мера неопределенности является функцией числа исходов f(n).

Можно указать некоторые свойства этой функции:

1. f(1) = 0, поскольку при n = 1 исход опыта не является случайным и, следовательно, неопределенность отсутствует;

2. f(n) возрастает с ростом n, поскольку чем больше число возможных исходов, тем более затруднительным становится предсказание результата опыта.

Для определения явного вида функции f(n) рассмотрим два независимых опыта  и

и

(для обозначения опытов со случайными исходами будем использовать греческие буквы ( ,

,  и т.д.),

и т.д.),

а для обозначения отдельных исходов опытов (событий) – латинские заглавные (A, B и т.д.) с количествами равновероятных исходов, соответственно  ,

,  .

.

Пусть имеет место сложный опыт, который состоит в одновременном выполнении опытов  и

и  ;

;

Число возможных его исходов равно  ·

· , причем, все они равновероятны.

, причем, все они равновероятны.

Очевидно, неопределенность исхода такого сложного опыта

будет больше неопределенности опыта

будет больше неопределенности опыта  , поскольку к ней добавляется неопределенность

, поскольку к ней добавляется неопределенность  ; мера неопределенности сложного опыта равна f(

; мера неопределенности сложного опыта равна f( ·

·  ).

).

С другой стороны, меры неопределенности отдельных  и

и  составляют, соответственно, f(

составляют, соответственно, f( ) и f(

) и f( ).

).

В первом случае (сложный опыт) проявляется общая (суммарная) неопределенность совместных событий, во втором – неопределенность каждого из событий в отдельности.

Однако из независимости  и

и  следует, что в сложном опыте они никак не могут повлиять друг на друга и, в частности,

следует, что в сложном опыте они никак не могут повлиять друг на друга и, в частности,  не может оказать воздействия на неопределенность

не может оказать воздействия на неопределенность  , и наоборот.

, и наоборот.

Следовательно, мера суммарной неопределенности должна быть равна сумме мер неопределенности каждого из опытов, т.е. мера неопределенности аддитивна:

(1.1)

(1.1)

Доказано, что единственная функцияf(n), из всех существующих классов функций удовлетворяющая свойствам (1) и (2) и соотношению (1.1) является log(n).

Таким образом: за меру неопределенности опыта с n равновероятными исходами можно принять число logа(n).

Выбор основания логарифма в данном случае значения не имеет, поскольку в силу известной формулы

преобразования логарифма logа(n) от одного основания а к другому основанию с состоит во введении одинакового для обеих частей выражения (1.1) постоянного множителя logca, что равносильно изменению масштаба (т.е. размера единицы) измерения неопределенности.

Исходя из этого, мы имеет возможность выбрать из каких-то дополнительных соображений основание логарифма.

Таким удобным основанием оказывается 2, поскольку в этом случае за единицу измерения принимается неопределенность, содержащаяся в опыте, имеющем лишь два равновероятных исхода, которые можно обозначить, например, ИСТИНА (True) и ЛОЖЬ (False) и использовать для анализа таких событий аппарат математической логики.

Единица измерения неопределенности при двух возможных равновероятных исходах опыта называется бит

(Название бит происходит от английского binary digit, что в дословном переводе означает "двоичный разряд" или "двоичная единица".)

Таким образом, функция, описывающей меру неопределенности опыта, имеющего n равновероятных исходов, может быть представлена в виде:

f(n) = log2n (1.2).

Эта величина получила название энтропии. В дальнейшем будем обозначать ее H.

Вновь рассмотрим опыт с n равновероятными исходами.

Поскольку каждый исход случаен, он вносит свой вклад в неопределенность всего опыта, но так как все n исходов равнозначны, разумно допустить, что и их неопределенности одинаковы.

Из свойства аддитивности неопределенности (1.1), а также того, что согласно (1.2) общая неопределенность равна log2n, следует, что неопределенность, вносимая одним исходом составляет

где

– вероятность любого из отдельных исходов.

Таким образом, неопределенность, вносимая каждым из равновероятных исходов, равна:

H = - p log2p (1.3).

Теперь попробуем обобщить формулу (1.3) на ситуацию, когда исходы опытов не равновероятны, например, p(A1) и p(A2).

Тогда:

H1 = - p(A1) log2 p(A1) и H2 = - p(A2) log2 p(A2)

H = H1 + H2 = -p(A1) log2 p(A1) - p(A2) log2 p(A2)

Обобщая это выражение на ситуацию, когда опыт  имеет n неравновероятных исходов A1, A2,..., An, получим:

имеет n неравновероятных исходов A1, A2,..., An, получим:

(1.4)

(1.4)

Введенная таким образом величина, как уже было сказано, называется энтропией опыта  .

.

Используя формулу для среднего значения дискретных случайных величин, можно записать:

H( ) = - log2 p (

) = - log2 p ( ),

),

где  – обозначает исходы, возможные в опыте

– обозначает исходы, возможные в опыте  .

.

Энтропия является мерой неопределенности опыта, в котором проявляются случайные события, и равна средней неопределенности всех возможных его исходов.

Для практики формула (1.4) важна тем, что позволяет сравнить неопределенности различных опытов со случайными исходами.

Пример 1. Имеются два ящика, в каждом из которых по 12 шаров.

- в первом – 3 белых, 3 черных и 6 красных;

- во втором – каждого цвета по 4.

Опыты состоят в вытаскивании по одному шару из каждого ящика. Что можно сказать относительно неопределенностей исходов этих опытов?

Согласно (1.4) находим энтропии обоих опытов:

, т.е. неопределенность результата в опыте

, т.е. неопределенность результата в опыте  выше и, следовательно, предсказать его можно с меньшей долей уверенности, чем результат

выше и, следовательно, предсказать его можно с меньшей долей уверенности, чем результат  .

.