Правила округления и записи результатов измерений.

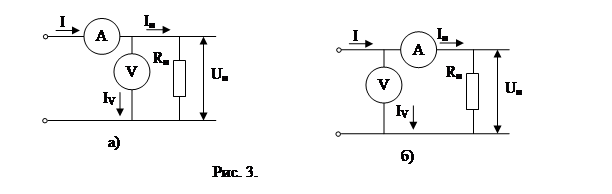

Рис. 2 Постоянная и переменная систематические погрешности

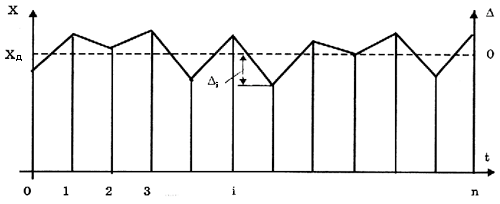

Рис. 1 Изменение случайной погрешности от изменения к измерению

Классификация погрешностей.

Основные понятия теории погрешностей.

Качество средств и результатов измерений принято характеризовать, указывая их погрешности. Введение понятия "погрешность" требует определения и четкого разграничения трех понятий: истинного и действительного значений измеряемой физической величины и результата измерения. Истинное значение физической величины - это значение, идеальным образом отражающее свойство данного объекта как в количественном, так и в качественном отношении. Оно не зависит от средств нашего познания и является той абсолютной истиной, к которой мы стремимся, пытаясь выразить ее в виде числовых значений. На практике это абстрактное понятие приходится заменять понятием "действительное значение". Действительное значение физической величины - значение, найденное экспериментально и настолько приближающееся к истинному, что для данной цели оно может быть использовано вместо него. Результат измерения представляет собой приближенную оценку истинного значения величины, найденную путем измерения.

Понятие "погрешность" - одно из центральных в метрологии, где используются понятия "погрешность результата измерения" и "погрешность средства измерения". Погрешность результата измерения - это разница между результатом измерения X и истинным (или действительным) значением Q измеряемой величины:

Понятие "погрешность" - одно из центральных в метрологии, где используются понятия "погрешность результата измерения" и "погрешность средства измерения". Погрешность результата измерения - это разница между результатом измерения X и истинным (или действительным) значением Q измеряемой величины:

Она указывает границы неопределенности значения измеряемой величины. Погрешность средства измерения - разность между показанием СИ и истинным (действительным) значением измеряемой ФВ. Она характеризует точность результатов измерений, проводимых данным средством.

Она указывает границы неопределенности значения измеряемой величины. Погрешность средства измерения - разность между показанием СИ и истинным (действительным) значением измеряемой ФВ. Она характеризует точность результатов измерений, проводимых данным средством.

Эти два понятия во многом близки друг к другу и классифицируются по одинаковым признакам.

Эти два понятия во многом близки друг к другу и классифицируются по одинаковым признакам.

По характеру проявления погрешности делятся на случайные, систематические, прогрессирующие и грубые (промахи).

По характеру проявления погрешности делятся на случайные, систематические, прогрессирующие и грубые (промахи).

Заметим, что из приведенного выше определения погрешности никак не следует, что она должна состоять из каких-либо составляющих. Деление погрешности на составляющие было введено для удобства обработки результатов измерений исходя из характера их проявления. В процессе формирования метрологии было обнаружено, что погрешность не является постоянной величиной. Путем элементарного анализа установлено, что одна ее часть проявляется как постоянная величина, а другая - изменяется непредсказуемо. Эти части назвали систематической и случайной погрешностями.

Заметим, что из приведенного выше определения погрешности никак не следует, что она должна состоять из каких-либо составляющих. Деление погрешности на составляющие было введено для удобства обработки результатов измерений исходя из характера их проявления. В процессе формирования метрологии было обнаружено, что погрешность не является постоянной величиной. Путем элементарного анализа установлено, что одна ее часть проявляется как постоянная величина, а другая - изменяется непредсказуемо. Эти части назвали систематической и случайной погрешностями.

Случайная погрешность - составляющая погрешности измерения, изменяющаяся случайным образом (по знаку и значению) в серии повторных измерений одного и того же размера ФВ, проведенных с одинаковой тщательностью в одних и тех же условиях. В появлении таких погрешностей (рис. 1) не наблюдается какой-либо закономерности, они обнаруживаются при повторных измерениях одной и той же величины в виде некоторого разброса получаемых результатов. Случайные погрешности неизбежны, неустранимы и всегда присутствуют в результате измерения. Описание случайных погрешностей возможно только на основе теории случайных процессов и математической статистики.

Случайная погрешность - составляющая погрешности измерения, изменяющаяся случайным образом (по знаку и значению) в серии повторных измерений одного и того же размера ФВ, проведенных с одинаковой тщательностью в одних и тех же условиях. В появлении таких погрешностей (рис. 1) не наблюдается какой-либо закономерности, они обнаруживаются при повторных измерениях одной и той же величины в виде некоторого разброса получаемых результатов. Случайные погрешности неизбежны, неустранимы и всегда присутствуют в результате измерения. Описание случайных погрешностей возможно только на основе теории случайных процессов и математической статистики.

В отличие от систематических случайные погрешности нельзя исключить из результатов измерений путем введения поправки, однако их можно существенно уменьшить путем увеличения числа наблюдений. Поэтому для получения результата, минимально отличающегося от истинного значения измеряемой величины, проводят многократные измерения требуемой величины с последующей математической обработкой экспериментальных данных.

В отличие от систематических случайные погрешности нельзя исключить из результатов измерений путем введения поправки, однако их можно существенно уменьшить путем увеличения числа наблюдений. Поэтому для получения результата, минимально отличающегося от истинного значения измеряемой величины, проводят многократные измерения требуемой величины с последующей математической обработкой экспериментальных данных.

Большое значение имеет изучение случайной погрешности как функции номера наблюдения i или соответствующего ему момента времени ti проведения измерений, т.е.

Большое значение имеет изучение случайной погрешности как функции номера наблюдения i или соответствующего ему момента времени ti проведения измерений, т.е.  i=

i= (ti) Отдельные значения погрешности являются значениями функции

(ti) Отдельные значения погрешности являются значениями функции  (t), следовательно, погрешность измерения есть случайная функция времени. При проведении многократных измерений получается одна реализация такой функции. Именно такая реализация показана на рис. 1. Повтор серии измерений даст нам другую реализацию этой функции, отличающуюся от первой, и т. д. Погрешность, соответствующая каждому i-му измерению, является сечением случайной функции

(t), следовательно, погрешность измерения есть случайная функция времени. При проведении многократных измерений получается одна реализация такой функции. Именно такая реализация показана на рис. 1. Повтор серии измерений даст нам другую реализацию этой функции, отличающуюся от первой, и т. д. Погрешность, соответствующая каждому i-му измерению, является сечением случайной функции  (t). В каждом сечении данной функции можно найти среднее значение, вокруг которого группируются погрешности в различных реализациях. Если через полученные таким образом средние значения провести плавную кривую, то она будет характеризовать общую тенденцию изменения погрешности во времени.

(t). В каждом сечении данной функции можно найти среднее значение, вокруг которого группируются погрешности в различных реализациях. Если через полученные таким образом средние значения провести плавную кривую, то она будет характеризовать общую тенденцию изменения погрешности во времени.

Систематическая погрешность - составляющая погрешности измерения, остающаяся постоянной или закономерно меняющаяся при повторных измерениях одной и той же ФВ. Постоянная и переменная систематические погрешности показаны на рис. 2. Их отличительный признак заключается в том, что они могут быть предсказаны, обнаружены и благодаря этому почти полностью устранены введением соответствующей поправки.

Систематическая погрешность - составляющая погрешности измерения, остающаяся постоянной или закономерно меняющаяся при повторных измерениях одной и той же ФВ. Постоянная и переменная систематические погрешности показаны на рис. 2. Их отличительный признак заключается в том, что они могут быть предсказаны, обнаружены и благодаря этому почти полностью устранены введением соответствующей поправки.

Следует отметить, что в последнее время, приведенное выше определение систематической погрешности, подвергается обоснованной критике, особенно в связи с техническими измерениями. Весьма аргументировано предлагается считать систематическую погрешность специфической, "вырожденной" случайной величиной, обладающей некоторыми, но не всеми свойствами случайной величины, изучаемой в теории вероятностей и математической статистике. Ее свойства, которые необходимо учитывать при объединении составляющих погрешности, отражаются теми же характеристиками, что и свойства "настоящих" случайных величин: дисперсией (средним квадратическим отклонением) и коэффициентом взаимной корреляции.

Следует отметить, что в последнее время, приведенное выше определение систематической погрешности, подвергается обоснованной критике, особенно в связи с техническими измерениями. Весьма аргументировано предлагается считать систематическую погрешность специфической, "вырожденной" случайной величиной, обладающей некоторыми, но не всеми свойствами случайной величины, изучаемой в теории вероятностей и математической статистике. Ее свойства, которые необходимо учитывать при объединении составляющих погрешности, отражаются теми же характеристиками, что и свойства "настоящих" случайных величин: дисперсией (средним квадратическим отклонением) и коэффициентом взаимной корреляции.

Грубая погрешность (промах) – это случайная погрешность результата отдельного наблюдения, входящего в ряд измерений, которая для данных условий резко отличается от остальных результатов этого ряда. Они, как правило, возникают из-за ошибок или неправильных действий оператора. Возможной причиной возникновения промахов также могут быть резкие кратковременные изменения условий проведения измерений. Если промахи обнаруживаются в процессе измерений, то результаты, их содержащие, отбрасывают. Однако чаще всего промахи выявляют только при окончательной обработке результатов измерений с помощью специальных критериев.

По способу выражения различают абсолютную, относительную и приведенную погрешности.

Абсолютная погрешность описывается формулой (1) и выражается в единицах измеряемой величины.

(1)

(1)

Относительная погрешность – это отношение абсолютной погрешности измерения к истинному значению измеряемой величины:

(2)

(2)

Приведенная погрешность – это относительная погрешность, в которой абсолютная погрешность СИ отнесена к условно принятому значению XN, постоянному во всем диапазоне измерений или его части:

(3)

(3)

Условно принятое значение XN называют нормирующим. Чаще всего за него принимают верхний предел измерений данного СИ.

В зависимости от места возникновения различают инструментальные, методические и субъективные погрешности.

Инструментальная погрешность обусловлена погрешностью применяемого СИ. Иногда эту погрешность называютаппаратурной.

Методическая погрешность измерения обусловлена:

· отличием принятой модели объекта измерения от модели, адекватно описывающей его свойство, которое определяется путем измерения;

· влиянием способов применения СИ;

· влиянием алгоритмов (формул), по которым производятся вычисления результатов измерений;

· влиянием других факторов, не связанных со свойствами используемых средств измерения.

Отличительной особенностью методических погрешностей является то, что они не могут быть указаны в нормативно-технической документации на используемое СИ, поскольку от него не зависят, а должны определяться оператором в каждом конкретном случае. В связи с этим оператор должен четко различать фактически измеряемую им величину и величину, подлежащую измерению.

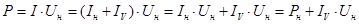

Пример. Определить в общем виде методическую погрешность измерения мощности постоянного тока косвенным методом по показаниям амперметра и вольтметра при двух схемах их включения, показанных на рис. 3. Внутренние сопротивления амперметра и вольтметра соответственно равны RA и RV.

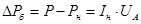

При использовании схемы на рис. 3, а измеренное значение мощности постоянного тока:

,

,

где I – ток, измеряемый амперметром; Iн – ток, протекающий через сопротивление нагрузки Rн; IV – ток, протекающий через вольтметр; Pн – действительное значение измеряемой мощности.

Абсолютная методическая погрешность измерения мощности по схеме на рис 3, а составляет

.

.

Относительная методическая погрешность в этом случае рассчитывается по формуле:

.

.

Аналогично для схемы на рис. 3, б измеряемое значение мощности:

,

,

где U – напряжение, измеряемое вольтметром; UА – падение напряжения на амперметре. При этом абсолютная методическая погрешность измерения мощности:

.

.

Относительная методическая погрешность в данном случае рассчитывается по формуле:

.

.

Анализ формул, описывающих относительные погрешности, показывает, что первую схему (рис. 3, а) целесообразно использовать для измерения низкоомных нагрузок, так как при  погрешность также стремится к нулю. По аналогичным причинам вторую схему (рис. 3, б) выгоднее применять для измерения мощности на высоомных нагрузках. Граница между высоомными и низкоомными нагрузками определяется в рассматриваемом случае параметрами используемых средств измерений. Действительно, из равенства методических погрешностей для каждой из схем получаем:

погрешность также стремится к нулю. По аналогичным причинам вторую схему (рис. 3, б) выгоднее применять для измерения мощности на высоомных нагрузках. Граница между высоомными и низкоомными нагрузками определяется в рассматриваемом случае параметрами используемых средств измерений. Действительно, из равенства методических погрешностей для каждой из схем получаем:

.

.

Пусть RА=0,002 Ом, а RV=1000 Ом, тогда Rн=1,41 Ом. В этом случае методическая погрешность измерения мощности составит 0,14%.

Субъективная (личная) погрешность измерения обусловлена погрешностью отсчета оператором показаний по шкалам СИ. Характеристики личной погрешности определяют на основе нормированной номинальной цены деления шкалы измерительного прибора с учетом способности “среднего оператора” к интерполяции в пределах деления шкалы.

Пример. Пусть цена деления равномерной шкалы равна Xд единиц измеряемой физической величины, длина деления равна Lд мм. Определить наибольшее значение личной погрешности.

При условии, что средний оператор может интерполировать в пределах деления шагами по 0,2 деления, т. е. по 0,2Lд, наибольшее значение личной погрешности:

.

.

По зависимости абсолютной погрешности от значений измеряемой величины различают погрешности (рис. 4):

· аддитивные  , не зависящие от измеряемой величины (рис. 4, а);

, не зависящие от измеряемой величины (рис. 4, а);

· мультипликативные  , которые прямо пропорциональны измеряемой величине (рис. 4, б);

, которые прямо пропорциональны измеряемой величине (рис. 4, б);

· нелинейные  , имеющие нелинейную зависимость от измеряемой величины (рис 4, в).

, имеющие нелинейную зависимость от измеряемой величины (рис 4, в).

Эти погрешности применяют в основном для описания метрологических характеристик СИ.

Примеры аддитивных погрешностей – от постоянного груза на чашке весов, от неточной установки на нуль стрелки прибора перед измерением, от термо-ЭДС в цепях постоянного тока.

Причинами возникновения мультипликативных погрешностей могут быть: изменение коэффициента усиления усилителя, изменение жесткости мембраны датчика манометра или пружины прибора, изменение опорного напряжения в цифровом вольтметре.

По влиянию внешних условий различают основную и дополнительную погрешности СИ.

Основной называется погрешность СИ, определяемая в нормальных условиях его применения. Для каждого СИ в нормативно-технических документах оговариваются условия эксплуатации – совокупность влияющих величин (температура окружающей среды, влажность, давление, напряжение и частота питающей сети и др.), при которых нормируется его погрешность.

Дополнительной называется погрешность СИ, возникающая вследствие отклонения какой-либо из влияющих величин.

В зависимости от влияния характера изменения измеряемых величин погрешности СИ делят на статические и динамические.

Статическая погрешность – это погрешность СИ применяемого для измерения ФВ, принимаемой за неизменную.

Динамической называется погрешность СИ, возникающая дополнительно при измерении переменной ФВ и обусловленная несоответствием его реакции на скорость (частоту) изменения измеряемого сигнала.

Эмпирически были установлены следующие правила округления рассчитанного значения погрешности и полученного результата измерения.

1. Погрешность результата измерения указывается двумя значащими цифрами, если первая из них равна 1 или 2, и одной – если первая цифра равна 3 или более. Пример: 0,00012; 0,0004.

2. Результат измерения округляется до того же десятичного знака, которым оканчивается округленное значение абсолютной погрешности. Если десятичная дробь в числовом значении результата измерений оканчивается нулями, то нули отбрасываются до того разряда, который соответствует разряду числового значения погрешности. Пример: результат 1,072000, погрешность ±0,0001. Результат округляют до 1,0720.

3. Если цифра старшего из отбрасываемых разрядов меньше 5, то остальные цифры числа не изменяются. Лишние цифры в целых числах заменяются нулями, а в десятичных дробях отбрасываются. Пример: 4567,343 округляют до 4567,34.

4. Если цифра старшего из отбрасываемых разрядов больше или равна 5, но за ней следуют отличные от нуля цифры, то последнюю оставляемую цифру увеличивают на единицу. Пример: 6783,6 округляют до 6784; 12,34501 до 12,35.

5. Если отбрасываемая цифра равна 5, а следующие за ней нули, то последнюю сохраняемую цифру не изменяют, если она четная, и увеличивают на единицу, если она нечетная. Пример: 1234,50 округляют до 1234; 8765,50 – до 8766.

6. Округление производится лишь в окончательном ответе, а все предварительные вычисления проводят с одним-двумя лишними знаками. Пример: результат 1,072000, погрешность ±0,0001. Вычисления производят с 1,07200.