Информационная энтропия

В соответствии со сказанным выше величина (I) может быть рассмотрена как мера неопределенности сведений об источнике информации, которая имела место до приема сообщений и была устранена после их получения. Эту меру неопределенности называют ЭНТРОПИЕЙ (H) источника информации, приходящейся на одно сообщение и считают эту величину его характеристикой. Таким образом, энтропия H источника на одно сообщение:

;

;

Как видно из полученной формулы количество информации и энтропия величины численно равные, но по смыслу противоположные.

Энтропии можно дать также другую формулировку: энтропия есть мера неопределенности (неупорядоченности, многообразия) ситуации, связанной с наличием определенного множества возможных сообщений, и измеряется она средним количеством информации, приходящимся на одно из этих сообщений.

Для источника с единственно возможным сообщением, вероятность которого приближается к единице (p  1), энтропия стремится к нулю (H

1), энтропия стремится к нулю (H  0).

0).

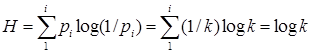

Если все k возможных сообщений источника равновероятны (  , то его энтропия H принимает максимальное значение:

, то его энтропия H принимает максимальное значение:

, так как

, так как

Поскольку каждому сообщению соответствует одно из возможных состояний источника, максимальная энтропия может служить мерой сложности и организованности системы, являющейся источником информации.