Дискретизация измерительных сигналов.

|

Дискретизация или квантование величин производится любым экспериментатором при считывании результатов измерений со шкалы аналогового измерительного прибора. В цифровых измерительных приборах и в аналого-цифровых преобразователях дискретизация непрерывных величин производится автоматически.

Дискретизация бывает двух видов:

по уровню (квантование) и по времени.

Квантование по уровню выполняется при численной регистрации любых экспериментальных данных. С математической точки зрения операция квантования связана с округлением значения непрерывной величины в соответствии с принятым правилом (например, отнесение к нижней, верхней границе интервала квантования или к его середине).

Сущность квантования непрерывного сигнала по уровню заключается в том, что все возможные значения непрерывной величины заменяют на определенные фиксированные значения, которые называют уровнями квантования.

Шаг квантования (квант) Δкв – разница между двумя соседними уровнями, может быть постоянным или изменяться по какому-либо закону.

На рисунке приведен пример квантованного сигнала, когда за уровень квантования принимается верхняя (рис. а)/ нижняя (рис. б)/ средняя (рис. в) граница интервала квантования.

При округлении значения x(t) вводится методическая погрешность квантования, называемая также шумом квантования

ξ(x) = Xi-X

х - текущее значение непрерывной величины.

Эта погрешность является неслучайной функцией случайного значения измеряемой величины. Погрешность квантования равна шагу квантования, если за уровень квантования принимается верхняя или нижняя граница интервала квантования. Если за уровень квантования принимается середина интервала, то погрешность квантования равна половине. (ξ (х) = Δкв/2)

Под дискретизацией сигнала по времени понимают процедуру преобразования непрерывного сигнала в дискретный, то есть это замена непрерывной по аргументу функции x(t) на функцию x(ti) дискретного аргумента ti. Таким образом в заданные моменты дискретизации ti фиксируются реальные значения x(t), при этом теряется информация о значении функции в любых других моментах времени. Шагом дискретизации называется промежуток времени между соседними значениями аргумента (Δt).

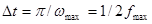

Дискретизация может осуществляться различным путем. Одна из процедур заключается в том, что непрерывный сигнал пропускают через ключ, который замыкается на очень короткие промежутки времени. Основной теоретической проблемой дискретизации измерительных сигналов по времени является выбор шага дискретизации. Эта проблема решается в рамках теоремы Котельникова. В соответствие с этой теоремой, если функция, описывающая измерительный сигнал удовлетворяет условиям Дирихле (ограничена, кусочно-непрерывна, имеет конечное число экстремумов), ее спектр ограничен некоторой частотой  , то существует такой максимальный интервал

, то существует такой максимальный интервал  между отсчетами, при котором имеется возможность безошибочного восстановления дискретизируемой функции по дискретным отсчетам, этот интервал

между отсчетами, при котором имеется возможность безошибочного восстановления дискретизируемой функции по дискретным отсчетам, этот интервал  , где

, где  носит название частоты Найквиста.

носит название частоты Найквиста.

Дискретизация непрерывной измеряемой величины по времени и по уровню в цифровом измерительном устройстве.